2019年春晚,无数中国家庭都围坐在一起边看春晚边抢红包。

随着春晚主持人通过口播让上亿观众使用百度APP抢红包之后,百度APP没有宕机,但是却“因为大量用户下载百度APP”, 一些第三方应用商店“瘫痪”了。苹果手机自带的应用下载工具也一度无法正常使用。

百度作为央视2019年春晚独家网络互动平台,在2月4日除夕夜发出4轮9亿红包。

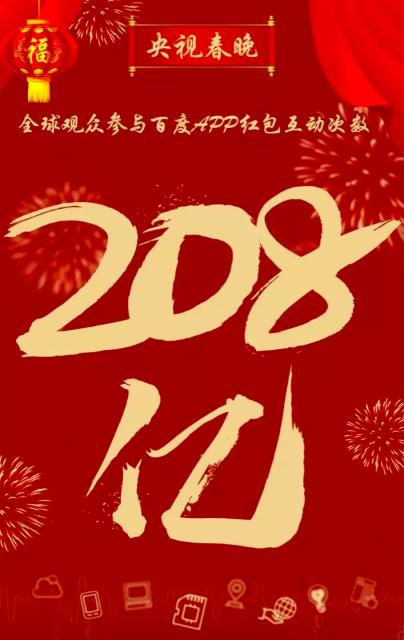

今年春晚的红包活动,全球观众参与互动活动次数达208亿次。

这背后,是百度云凭借稳健的服务和过硬的技术,经受住 “史上最大红包流量”的考验。

今年百度APP春晚红包互动活动涉及百度数十个产品、百余种用户场景,加上春晚的超高收视率,给百度云带来压力不小的“三大挑战”:临时用户登录量极大、瞬间出现巨大流量峰值、短期资源需求量巨大。

稍有支持不力,都可能导致用户打开百度APP缓慢、无法登录自己的账号、点击界面无反应,甚至出现白屏,更别说参与抢红包大战。

为此,百度技术部门全体动员,从多个方面着手,进行了周密的规划准备工作。

在从项目启动到上线的30天内,展开实施产品运营优化、数据库优化、智能调度、技术设施运维等全方位应对方案,打了一场多线并行、内外协同的高效技术服务保障战役。

面对临时用户登录量极大的难题,百度云20天内将短信承接能力提升至少数十倍,还与运营商合作,在云上布局一键登录功能,简化登录流程、减轻服务器压力。

对于红包福利活动中出现的小度商城,百度云也提供了先进的存储、计算等技术支持。

不止于“摇一摇”、“扫一扫”,今年春晚互动新增更多AI玩法,相应也带来了一波又一波“高并发、大流量”的惊险时刻。

在瞬间可能出现的巨大流量峰值面前,百度工程师对用户刚登录APP时的内容加载进行优化,并通过智能调度系统,依据用户行为的不同,层层计算,调度早已准备好的冗余资源,增加系统容量,合理分配带宽,通过这些措施保证亿级用户可以流畅体验不同的抢红包任务。

另外,为了应对短期资源需求量巨大的难题,百度系统部作为资源供应、技术保障团队,在关键设施资源供应及运营保障方面发挥了极其关键作用。

- 在全国各个地区提前规划和布局了多个数据中心集群,确保机架位资源充足供应,机房动力环境100%安全稳定运行。

- 弹性供应链可以应对业务陡增的刚性需求,保障服务器资源及时、高效交付。

- 敏捷高效的自动化处理平台,灵活调整并发限制。

- 业界领先的百度自研整机柜技术,为春晚项目提供高可信的计算、存储能力。

- 提前规划布局和建设的网络资源,通过智能调度系统,分钟感知不同地区资源紧张程度,进行相应的资源调度和补给。

比如,北京顺义华威机房在8小时内完成了10000台服务器的物理上架,16小时完成自动化上线交付业务使用,创造了业界服务器交付速度的新纪录;IDC网络和CDN资源建设则在3周内完成了相当于2018年全年的建设量。

今年的春晚红包互动,对于百度云既是一次挑战,也是一块试金石。

面对高于平日千百倍的数据吞吐量,百度云用自身充足的准备和先进的技术能力,保障了用户的顺畅体验和活动的顺利进行,经受住了春晚流量洪峰的考验!

关注百度云微信公众号,了解更多 ')}